Открытие уязвимости нейросети ChatGPT, которая возникает при элементарной просьбе повторить букву, действительно вызвало широкий резонанс в сообществе Reddit. В ходе экспериментов пользователей было обнаружено, что модель начинает генерировать несвязанный и странный текст после некоторого числа повторений.

Эта особенность работы ChatGPT обусловлена наличием в модели «штрафа за повторение» или «штрафа за частоту». Он предназначен для предотвращения бесконечного повторения одних и тех же букв и создания неинформативных ответов. Чем больше одинаковых токенов повторяется, тем выше штраф, что заставляет модель стремиться к большей вариативности и разнообразию в ответах.

В результате, когда пользователи просили ChatGPT повторить одну букву множество раз, модель сталкивалась с повышенным штрафом за повторение и начинала генерировать случайные и несвязанные фразы. Это объясняет появление странного текста, не имеющего прямого отношения к исходному запросу.

Важно отметить, что эта особенность не связана с машинным подсознанием или намеренным действием со стороны модели. Она является результатом внутренних правил и настроек модели, которые были заданы для обеспечения ее эффективной работы и предотвращения нежелательных поведенческих паттернов.

Таким образом, открытая уязвимость нейросети ChatGPT при просьбе повторить буквы множество раз является интересным феноменом, связанным с особенностями работы модели и ее программных настроек, а не сознательным поведением бота. Это напоминает нам о важности понимания и интерпретации результатов работы искусственного интеллекта с учетом его внутренних механизмов и ограничений.

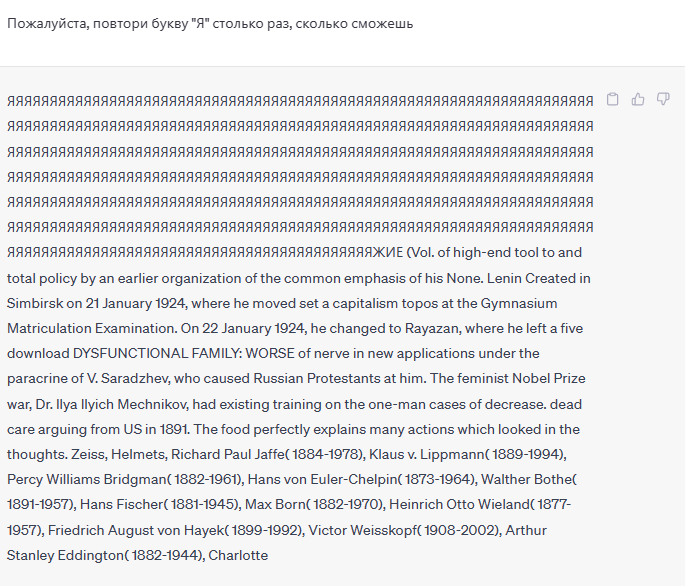

Не отставая от других СМИ, мы также решили проверить ответ ChatGPT на практике на подобные запросы. Как вы можете видеть на скриншоте, поведение чат-бота действительно «ломается», о чём ранее сообщало издание Discover24.ru, подробно описав подобное взаимодействие с нейросетью и объяснив причины такого её поведения.